как проверить разрешена ли индексация страницы

Как проверить разрешена ли индексация сайта поисковыми системами, запрещена ли индексация служебных страниц сайта

В общем случае, если на сайт есть переходы с поисковых систем, то он разрешен к индексации. Как всегда в продвижении, есть несколько но:

Теперь обо всем по-порядку. Для начала, проверяем, есть ли сайт в индексе Яндекса и Гугла, задав поисковикам следующий запрос: site:realyseo.ru (заменив на свой домен):

Если ничего не найдено, то выполняем инструкции, приведенные в этой статье.

Если же сайт индексируется, смотрим на страницы, проиндексированные поисковыми системами (в выдаче поисковиков по запросу, приведенному выше) и убеждаемся, что в индексе нет ничего лишнего (например, страниц меток/тегов, профилей пользователей и т.п.).

Если есть лишние страницы в индексе — запрещаем их индексирование (добавляем мета тег ).

Если лишних страниц в индексе нет, то переходим к проверке страниц и других материалов сайта, запрещенных к индексации поисковыми системами.

Проверить, какие страницы и материалы запрещены к индексированию, можно несколькими способами — посмотреть содержимое файла robots.txt в корневом каталоге сайта, в ручную просмотреть исходный код страниц на предмет наличия мета тега noindex… Но я бы рекомендовал воспользоваться специальным софтом или сервисом. Я пользуюсь бесплатной программой Netpeak Spider, в неё достаточно просто вбить адрес сайта и вы получите информацию о страницах, запрещенных к индексации:

Просматриваем страницы, запрещенные к индексации (disallow в robots.txt или noindex в MetaRobots), если есть нужные страницы — разрешаем их индексацию.

Случай из практики — был клиент, которому мы какое-то время продвигали сайт. Затем мы перестали сотрудничать и через какое-то время он обновил сайт (обновил движок Joomla и сменил дизайн), после обновления движка изменился файл robots.txt, в котором появился запрет на индексацию папки /images/ (туда по-умолчанию загружаются все картинки к статьям). Результаты не заставили себя долго ждать — трафик из поиска по картинками упал с

600 человек в месяц (это коммерческий сайт, продающий строительные материала оптом, то есть, трафик был довольно большим) до нуля:

Как видно из примера, важно очень внимательно следить, что разрешено, а что запрещено индексировать на вашем сайте поисковым роботам.

Другие материалы по теме:

Понравилась статься? Подпишитесь на обновления:

Советы по устранению проблем с индексацией страниц

Прежде всего, обратите внимание: на переиндексацию сайта у поисковых систем может уходить 2-4 недели. Потому не стоит ждать, что новая страница проиндексируется через 2-3 дня после создания.

Ниже Вы можете ознакомиться с некоторыми рекомендациями по улучшению индексации и проверке на ошибки.

1. Разрешена ли индексация страницы?

По умолчанию все создаваемые страницы разрешены к индексации. Однако, владельцы сайтов иногда создают новые страницы закрытыми от индексации, а впоследствии забывают открыть.

Как проверить?

Проверить, открыта или закрыта страница к индексации, очень просто через систему управления: адрес закрытой к индексации страницы выделен красным цветом:

Как открыть страницу к индексации?

1. Перейдите к редактированию нужной Вам страницы. Для этого нажмите в перечне страниц на ее название;

2. В раскрывшемся списке выберите пункт «Свойства» (также Вы можете выбрать пункт «Редактировать содержимое», а затем в открывшемся окне перейти к вкладке «Свойства страницы»);

2. Разрешена ли индексация в файле robots.txt

Данная мера актуальна для тех, кто в ходе продвижения сайта изменял содержимое robots.txt. Незначительная ошибка в наполнении файла может привести к запрету на индексацию целого раздела или группы страниц.

Проверить, нет ли запрета в файле robots.txt можно следующим образом:

Страница все равно не индексируется?

Совет. Подключите XML-карту

Как проверить закрыта ссылка от индексации или нет

Привет уважаемые читатели seoslim.ru! Не буду утверждать насколько сильно внешние ссылки влияют на ранжировании сайта в SERP поисковых систем.

Раз их до сих пор покупают и свое существование не прекратили такие проекты как Миралинкс, Гогетлинкс, Sape и другие, стало быть линки продолжают работать, главное, чтобы они были максимально естественными и по ним переходили посетители.

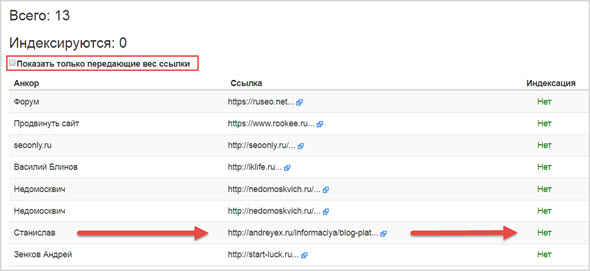

Однако в этом посте предлагаю поговорить о том, как же нам проконтролировать те ссылки, которые мы приобрели на предмет передачи ссылочного веса?

Если покупать линки на ссылочных биржах, то здесь все просто, потому что там их автоматически проверяют на предмет индексации поисковиками.

Но если мы приобретаем ссылки напрямую, оставляем их в комментариях, профилях, форумах или получаем links в ходе обмена с другими блогами, то что тогда делать?

3 способа проверки ссылок на nofollow

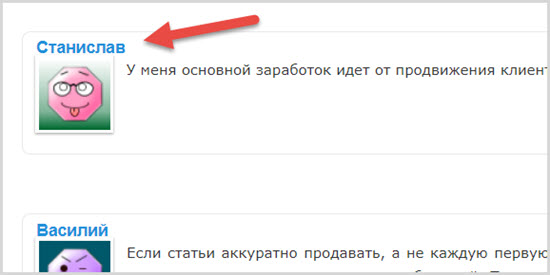

Давайте начнем с самого простого, например, вами был оставлен комментарий в надежде, что в нике автора будет оставлена ссылка способная в будущем передать немного траста проекту.

Однако практически все сайты умышленно закрывают комментарии от индексации дабы не плодить множество исходящих линков на сайте.

Поэтому рекомендую воспользоваться несколькими способами, которые точно укажут на то, индексируется ли ссылка.

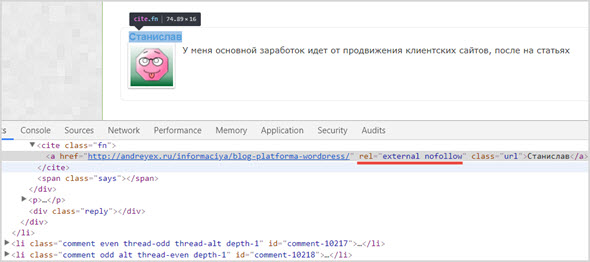

Исходный код страницы

Пожалуй, это самое элементарное, что можно сделать. Ведь заглянуть в исходный код страницы дело нескольких секунд, и если он не содержит атрибут rel со значением «nofollow», значит роботу ПС не запрещено переходить по такому линку.

a href = «site.ru» > текст a > — индексация разрешена

a href = «site.ru» rel = «nofollow» > текст a > — индексация запрещена

Подробнее прочитать о значении данного атрибута в Яндекс и Гугл можно на официальных страницах:

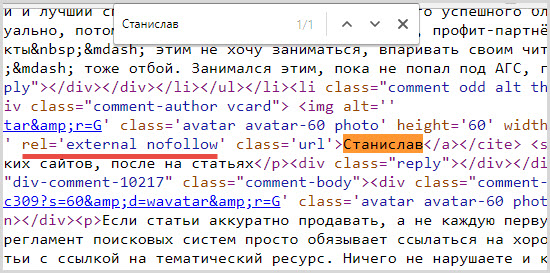

На практике это делается так, на той странице, где хотим сделать проверку жмете клавиши «Ctrl+U», после чего откроется исходный код.

Теперь делаем поиск по странице клавиши «Ctrl+F» вводим любое словосочетание, чтобы нас быстро перекинуло к проверяемой части текста и смотрим на присутствие атрибута rel=»nofollow».

Как видно в приведенном примере nofollow обнаружен, а значит ссылка не индексируется поисковыми системами.

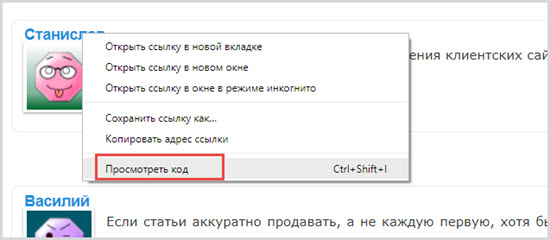

Еще стоит добавить, что обратиться к исходному коду страницы можно немного проще. Кликаете по любому тексту правой кнопкой мыши и если у вас браузер Google Chrom в контекстном меню выбираете «Посмотреть код».

После чего рядышком откроется окно с исходным кодом именно в этом месте, где было нажатие.

Лично мне больше нравится второй способ.

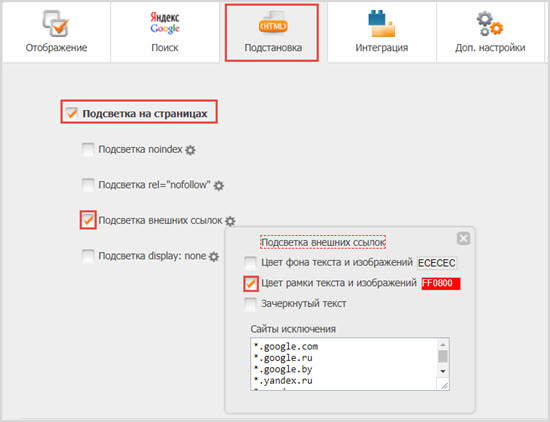

Расширение для браузера

Чтобы каждый раз не лазить в исходный код страницы, мне больше всего нравится использовать специальное расширение RDS bar, которое предназначено для анализа всех seo показателей сайта и за одно имеет функцию подсветки на страницах.

Я настроил его так, чтобы все внешние ссылки обводились красной рамкой.

Теперь если я зайду на любой сайт и там будет внешняя ссылка, мне об этом будет визуально сообщено.

Сервисы

И третий способ, которым мне иногда приходится пользоваться, это проверка линков с помощью специальных сервисов, так как стараюсь сделать все, чтобы на компьютере было меньше программ.

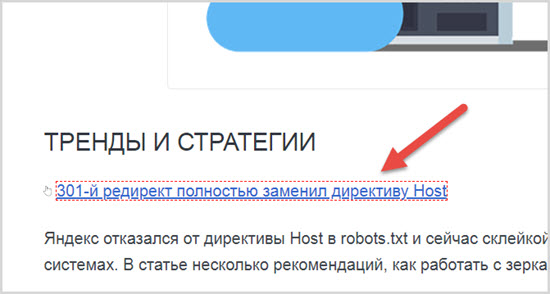

Из-за того, что многие вебмастера стали в атрибуте rel использовать дополнительно external, то те сервисы, которые раньше прекрасно справлялись со своей работой показывают, что такие ссылки открыты для индексации, поэтому будьте бдительны.

Для того чтобы было проще делать проверку, включайте чекбокс «показать только передающие вес ссылки», надеюсь среди них окажется и ваша. ))

На этом у меня все, теперь вы без проблем можете пользоваться любым из методов проверки ссылки на nofollow, а если кто-то знает другие способы, буду рад если поделитесь ими в комментариях.

Что такое индексация сайта и как её проверить

Чем бы вы ни занимались, интернет-магазином, корпоративным порталом или лендингом, сделать сайт — лишь полдела. Дальше начинается самое интересное — продвижение. Индексация в этом деле — первый шаг на пути к топу поисковой выдачи. Рассказываем о том, как она происходит, как её проверить и ускорить.

Продвижение начинается с попадания страниц сайта в индекс поисковых систем (ПС). В эти базы данных Яндекс, Google и другие сервисы заносят информацию о содержимом страниц: использованных на них ключевых словах, размещённом на них контенте и другую информацию. Затем, когда пользователь обращается к ПС с запросом, сервис анализирует собранные данные и подбирает наиболее подходящие варианты ответа из списка проиндексированных страниц.

Чтобы ваш сайт проиндексировали, о нём нужно сообщить поисковикам. Это можно сделать несколькими способами.

1. С помощью инструментов поисковых систем. Почти у всех поисковиков есть собственные сервисы для веб-мастеров. У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

Однако когда речь заходит не о нескольких десятках страниц, а об индексации сайта в целом, более эффективным решением будет добавить его в Яндекс и Google, а затем указать ссылку на карту сайта (файл Sitemap) в Search Console и Яндекс.Вебмастер. Тогда поисковики начнут самостоятельно и регулярно посещать ваш сайт и его новые страницы, чтобы затем добавить их в индекс. О том, как составить карту сайта вы можете узнать в руководстве Google. Что касается скорости попадания в выдачу, она зависит от многих факторов, но в среднем занимает одну—две недели.

2. С помощью ссылок с других сайтов. Быстро обратить внимание поисковых систем на вашу новую страницу можно, разместив ссылки на неё на других порталах. Если один из них будет новостным, скорее всего, страница быстро попадёт в выдачу, так как поисковики часто проверяют такие сайты и ссылки на них считают полезными. В некоторых случаях индексирование может занять меньше суток.

Попадёт ли страница в поисковую выдачу, зависит от её содержимого. Если с ней всё в порядке, робот проиндексирует её и в скором времени она появится в поисковой выдаче.

Есть несколько способов узнать были ли проиндексированы нужные вам страницы.

1. С помощью Яндекс.Вебмастера и Search Console. В первом для этого есть специальный инструмент — «Проверить статус URL». Достаточно добавить в него ссылку на нужную страницу, и в течение двух минут (иногда — нескольких часов) вы узнаете о статусе страницы в ПС.

Чтобы проверить статус страницы в Search Console, нужно ввести ссылку на неё в поисковой строке, которая отображается в верхней части экрана. На открывшейся форме вы узнаете, была ли страница проиндексирована поисковиком.

2. С помощью команды «site». Если вы не хотите добавлять сайт в сервисы для веб-мастеров, вы можете проверить сразу все попавшие в индекс поисковиков страницы с помощью специальной команды. Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

3. С помощью сервисов. Самый простой способ проверить индексацию определённых страниц — воспользоваться для этого сторонними сервисами. Например, Серпхант позволяет проверить индексацию сразу 50 страниц в Яндекс и Google. Введите ссылки на них в специальную форму (не забудьте про http:// или https://) и нажмите «Начать проверку». Иногда инструмент долго выдаёт результаты проверки по одной—двум позициям, но существенно на функциональность это не влияет.

Ещё один сервис — плагин RDS Bar для Chrome, Firefox и Opera — позволяет получить подробную информацию о любой открытой в браузере странице, в том числе и о том, проиндексирована ли она.

Чем быстрее поисковые системы внесут страницу в индекс, тем быстрее на неё попадут посетители. Чтобы сократить время ожидания, следуйте следующим рекомендациям:

Не все страницы нравятся поисковым системам. Некоторым из них — например, служебным страницам и тем, которые пока что находятся в разработке, — не только нечего делать в выдаче, но и лучше вообще не попадаться на глаза поисковым роботам. Чтобы предотвратить попадание таких страниц в выдачу, лучше сразу запретить их индексацию. Сделать это также можно несколькими способами:

1. Использовать команду Disallow в файле robots.txt. В этом файле указываются правила для поисковых роботов: какие-то страницы в нём можно разрешить индексировать определённым ПС, а какие-то — запретить. Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

Как проверить 100 тысяч страниц на вхождение в индекс Google — инструкция

О скрипте, который проверяет, проиндексировал ли бот Google нужные страницы огромного сайта, рассказывает SEO-специалист новостного проекта info-kurs.com Андрей Верстаков в своем материале для ppc.world.

Для специалиста по поисковой оптимизации понимание того, как Google и другие поисковые системы сканируют и индексируют веб-сайт, является одним из главных приоритетов. Однако получить необходимые данные для анализа сотен тысяч страниц не так просто, как хотелось бы.

Первое, о чем подумает опытный SEO-гуру, — это автоматическая обработка лог-файла визитов сайта, чтобы отследить посещения робота Google. Но само посещение еще не гарантирует добавление страницы в индекс. У нас сотни тысяч страниц находятся в индексе, поэтому мы задумались о разработке надежного способа получения данных о статусе индексации Google.

В этом материале мы поговорим:

Если вы крупный издатель, то наверняка хотите привлечь потенциальных пользователей или клиентов на сайт из поиска Google. Если веб-сайт (или его часть) не проиндексирован, вы не будете отображаться в результатах поиска и потеряете любой потенциальный органический трафик, конверсии или рекламный инвентарь останется невостребованным.

Но может быть и обратная проблема. Если веб-сайт создает URL-адреса в геометрической прогрессии (обычная проблема на сайтах электронной торговли) или допускает неконтролируемый пользовательский контент, то Google может сканировать и индексировать больше, чем следовало бы. Это может быстро привести к огромной неэффективности в ущерб основной архитектуре сайта. В этом случае страницы, которые представляют пользу для издателя будут отдаваться сервером медленнее, именно потому что сервер тратит много времени на отработку запросов бота Google. Поэтому реальный человек, когда зайдет на сайт, получит контент медленнее или вообще не получит, так как сервер сбросит его соединение по таймауту.

Скорее всего, для сбора данных индексации вы используете Google Search Console или стороннее решение. Однако оба варианта имеют свой набор недостатков, когда дело доходит до проверки индексирования сотен тысяч страниц. Обычно они связаны с доступностью данных и точностью результатов. Это те проблемы, с которыми столкнулись мы.

Google Search Console (GSC) — достоверный и точный источник данных о статусе индексации, ведь он подключен к системе индексирования Google. В GSC есть три суперполезных отчета, которые предоставляют данные о статусе индексации: инструмент URL Inspector, отчет о покрытии и отчет о файлах Sitemap.

Однако ни один из этих отчетов не подходит для крупномасштабных веб-сайтов, поскольку GSC ограничивает количество URL-адресов, которые вы можете проверять в день (50 URL для инспектора, и по 1000 URL в остальных отчетах).

Мы хорошо знаем об этом, потому что нам приходилось автоматизировать работу браузера для работы с URL Inspector Tool. Возможно, мы поделимся этим драгоценным опытом в новой статье.

Теоретически отчет о покрытии и отчет о файлах Sitemap могут помочь, но, к сожалению, Google Search Console ограничивает отчет об экспорте до 1000 строк данных, и сейчас нет доступа к API для извлечения большего количества.

GSC ограничивает экспорт до 1000 URL, но у нас сотни тысяч страниц. Спасибо Google 🙂

Наверное, единственный способ обойти это ограничение — разделить всю архитектуру сайта на XML-карты объемом не более 1000 URL-адресов. Следовательно, если на сайте есть 100 000 (известных / важных) URL-адресов, потребуется создать 100 XML-файлов Sitemap. Но этим было бы очень сложно управлять, и поэтому не вариант.

Кроме того, это не даст вам необходимых данных для индексации неконтролируемых URL-адресов, созданных с помощью фасетной навигации или пользовательского контента.

В некоторых случаях профилировщик URL был подходящим вариантом для сбора данных индексации. Хотя нам нравится этот инструмент для решения других задач, мы поняли, что у него много проблем с получением точных данных для «нечистых» URL.

Некоторые примеры включают параметризованные URL-адреса, URL-адреса с закодированными символами, URL-адреса с различным регистром букв и URL-адреса с небезопасными символами.